LLaVA: Großer Sprach- und Sehassistent

LLaVA LLaVA: Großer Sprach- und Sehassistent

Haotian Liu*, Chunyuan Li*, Qingyang Wu, Yong Jae Lee,

▶ University of Wisconsin-Madison ▶ Microsoft Research ▶ Columbia University *Gleicher Beitrag

arXiv-Code-Demo-Datensatzvorlage

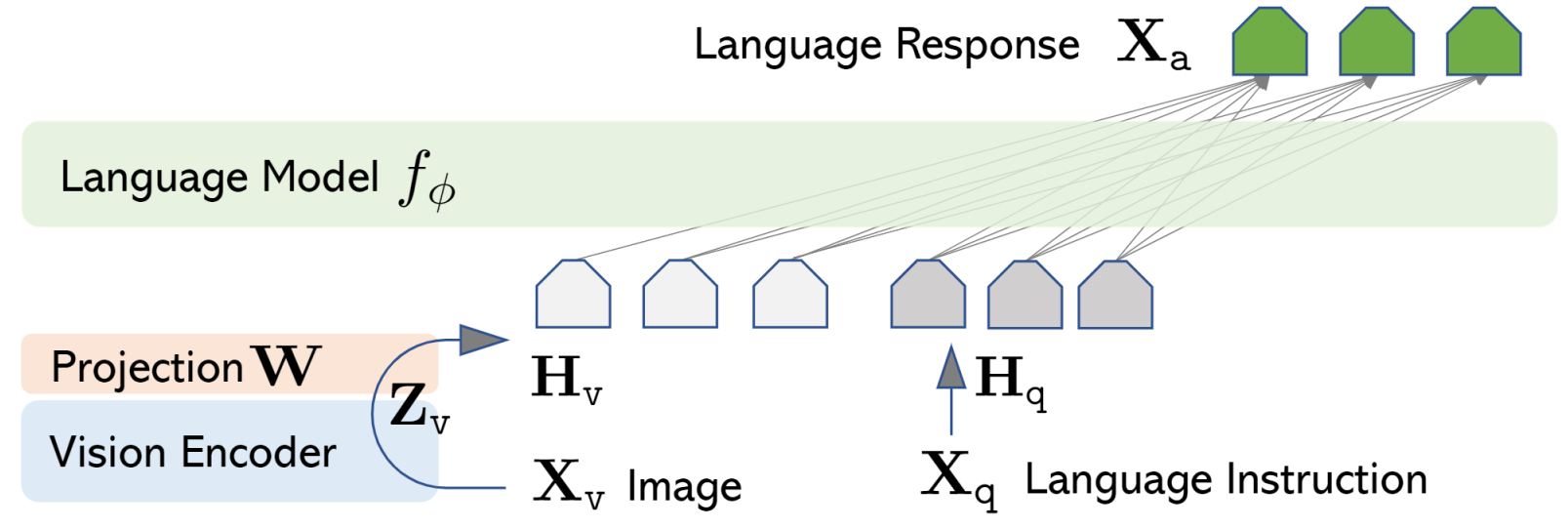

LLaVA stellt ein neues großes multimodales End-to-End-Modell dar, das einen Vision-Encoder und Vicuna für allgemeines visuelles und sprachliches Verständnis kombiniert, beeindruckende Chat-Fähigkeiten erreicht, die den Geist des multimodalen GPT-4 nachahmen und einen neuen Stand der -Genauigkeit etablieren der Kunst auf Wissenschaft QA. AbstraktDas Optimieren von Large Language Model (LLM)-Anweisungen unter Verwendung von maschinengenerierten Anweisungsverfolgungsdaten hat die Zero-Firing-Fähigkeiten bei neuen Aufgaben im Sprachbereich verbessert, aber die Idee wird im multimodalen Bereich weniger erforscht.

Multimodale Anweisungsdaten. Wir präsentieren den ersten Versuch, die GPT-4-Sprache nur zu verwenden, um multimodale Sprachbild-Anweisungsverfolgungsdaten zu generieren. LLAVA-Modell. Wir stellen LLaVA (Large Language-and-Vision Assistant) vor, ein großes, durchgängig trainiertes, multimodales Modell, das einen Vision-Encoder und ein LLM für allgemeines visuelles und sprachliches Verständnis verbindet. Leistung. Unsere frühen Experimente zeigen, dass LLaVA beeindruckende Multi-Modell-Katzenfähigkeiten demonstriert, manchmal das Verhalten von multimodalem GPT-4 auf unsichtbaren Bildern/Anweisungen zeigt und eine relative Punktzahl von 85,1 % gegenüber GPT-4 auf einer Reihe von synthetischen multimodalen Daten erzielt folgende Anweisungen. Bei der Verfeinerung auf Science QA erreicht die Synergie von LLaVA und GPT-4 eine neue Spitzengenauigkeit von 92,53 %. Open Source. Wir stellen die von GPT-4, unserem Modell und unserer Codebasis, generierten Tuning-Daten für visuelle Anweisungen öffentlich zur Verfügung.Basierend auf dem COCO-Datensatz interagieren wir nur mit der GPT-4-Sprache und sammeln insgesamt 158.000 einzigartige Beispiele von Sprachbildanweisungen, darunter 58.000 in Konversationen, 23.000 in der detaillierten Beschreibung bzw. 77.000 in der komplexen Argumentation. Siehe ``LLaVA-Instruct-150K''' auf [HuggingFace Dataset].

Haotian Liu*, Chunyuan Li*, Qingyang Wu, Yong Jae Lee,

▶ University of Wisconsin-Madison ▶ Microsoft Research ▶ Columbia University *Gleicher Beitrag

arXiv-Code-Demo-Datensatzvorlage

LLaVA stellt ein neues großes multimodales End-to-End-Modell dar, das einen Vision-Encoder und Vicuna für allgemeines visuelles und sprachliches Verständnis kombiniert, beeindruckende Chat-Fähigkeiten erreicht, die den Geist des multimodalen GPT-4 nachahmen und einen neuen Stand der -Genauigkeit etablieren der Kunst auf Wissenschaft QA. AbstraktDas Optimieren von Large Language Model (LLM)-Anweisungen unter Verwendung von maschinengenerierten Anweisungsverfolgungsdaten hat die Zero-Firing-Fähigkeiten bei neuen Aufgaben im Sprachbereich verbessert, aber die Idee wird im multimodalen Bereich weniger erforscht.

Multimodale Anweisungsdaten. Wir präsentieren den ersten Versuch, die GPT-4-Sprache nur zu verwenden, um multimodale Sprachbild-Anweisungsverfolgungsdaten zu generieren. LLAVA-Modell. Wir stellen LLaVA (Large Language-and-Vision Assistant) vor, ein großes, durchgängig trainiertes, multimodales Modell, das einen Vision-Encoder und ein LLM für allgemeines visuelles und sprachliches Verständnis verbindet. Leistung. Unsere frühen Experimente zeigen, dass LLaVA beeindruckende Multi-Modell-Katzenfähigkeiten demonstriert, manchmal das Verhalten von multimodalem GPT-4 auf unsichtbaren Bildern/Anweisungen zeigt und eine relative Punktzahl von 85,1 % gegenüber GPT-4 auf einer Reihe von synthetischen multimodalen Daten erzielt folgende Anweisungen. Bei der Verfeinerung auf Science QA erreicht die Synergie von LLaVA und GPT-4 eine neue Spitzengenauigkeit von 92,53 %. Open Source. Wir stellen die von GPT-4, unserem Modell und unserer Codebasis, generierten Tuning-Daten für visuelle Anweisungen öffentlich zur Verfügung.Basierend auf dem COCO-Datensatz interagieren wir nur mit der GPT-4-Sprache und sammeln insgesamt 158.000 einzigartige Beispiele von Sprachbildanweisungen, darunter 58.000 in Konversationen, 23.000 in der detaillierten Beschreibung bzw. 77.000 in der komplexen Argumentation. Siehe ``LLaVA-Instruct-150K''' auf [HuggingFace Dataset].

What's Your Reaction?