У нас могут закончиться данные для обучения языковых программ ИИ

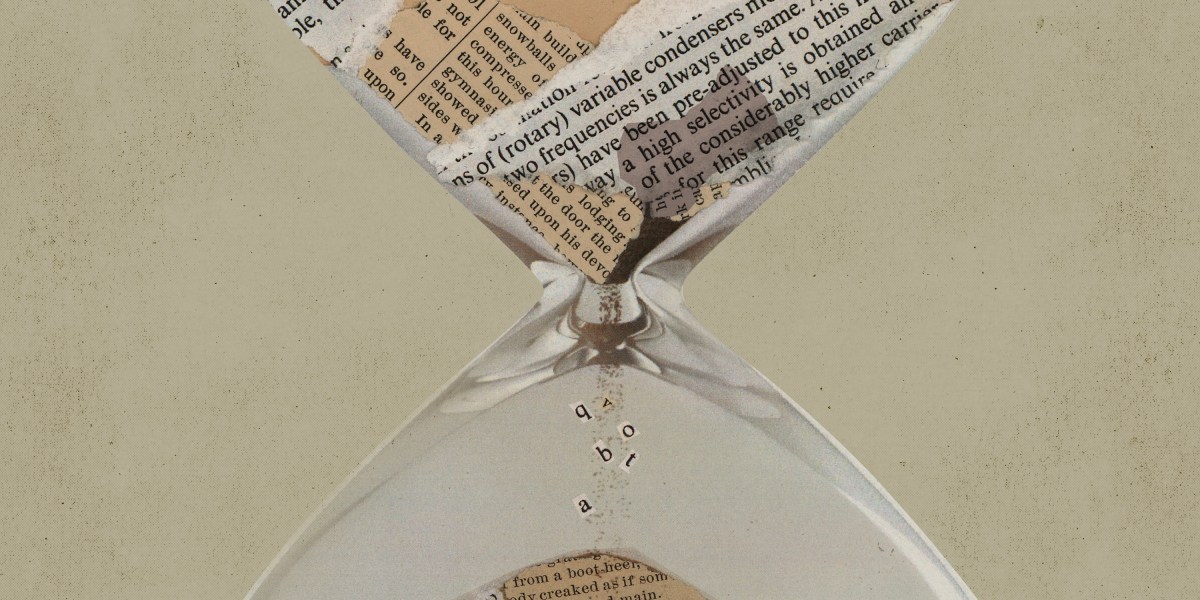

Большие языковые модели — одна из самых популярных областей исследований ИИ в настоящее время, и компании спешат выпускать такие программы, как GPT-3, которые могут писать невероятно последовательные документы и даже компьютерный код. Но, по словам группы прогнозистов искусственного интеллекта, на горизонте маячит проблема: у нас могут закончиться данные для их обучения.

Лингвистические модели обучаются с использованием текста из таких источников, как Википедия, новостные статьи, научные статьи и книги. В последние годы появилась тенденция обучать эти модели на все большем количестве данных в надежде сделать их более точными и универсальными.

Проблема заключается в том, что типы данных, обычно используемые для обучения языковых моделей, могут быть исчерпаны в ближайшем будущем, уже в 2026 году. пока доступно. подвергаться экспертной оценке. Проблема в том, что по мере того, как исследователи создают более мощные модели с большими возможностями, им приходится находить все больше и больше текстов для их обучения. Ведущие исследователи языковых моделей все больше обеспокоены тем, что у них заканчиваются данные такого рода, говорит Тевен Ле Скао, исследователь из компании Hugging Face, занимающейся искусственным интеллектом, которая не участвовала в работе Epoch.

>Отчасти проблема заключается в том, что исследователи ИИ фильтруют данные, которые они используют для обучения моделей, по двум категориям: высокого и низкого качества. Граница между этими двумя категориями может быть размыта, говорит Пабло Вильялобос, исследователь Epoch и ведущий автор статьи, но текст первой считается написанным лучше и часто создается профессиональными писателями.

Данные в низкокачественных категориях состоят из текста, такого как сообщения в социальных сетях или комментарии на таких сайтах, как 4chan, и таких примеров значительно больше, чем считается высококачественным. Исследователи обычно обучают модели только с использованием данных, которые попадают в категорию высокого качества, потому что именно такой язык они хотят, чтобы модели воспроизводили. Этот подход дал впечатляющие результаты для больших языковых моделей, таких как GPT-3.

По словам Свабхи Сваямдипты, профессора машинного обучения Университета Южной Калифорнии, который специализируется на качестве наборов данных, одним из способов преодоления этих ограничений данных может быть переоценка того, что определяется как "низкое" и "высокое". По словам Сваямдипты, если нехватка данных заставит исследователей ИИ включать более разнообразные наборы данных в процесс обучения, это будет "чистым плюсом" для языковых моделей.

Исследователи также могут найти способы продлить срок службы данных, используемых для обучения языковых моделей. В настоящее время эти модели обучаются только один раз на одних и тех же данных из-за ограничений производительности и стоимости. Но может быть возможно обучить модель несколько раз, используя одни и те же данные, говорит Сваямдипта.

Некоторые исследователи считают, что когда речь идет о языковых моделях, большой не обязательно означает лучший. Перси Лян, профессор компьютерных наук в Стэнфордском университете, говорит, что есть доказательства того, что повышение эффективности моделей может повысить их производительность, а не только увеличить их размер. "Мы увидели, как небольшие модели, обученные на данных более высокого качества, могут превзойти более крупные модели, обученные на данных более низкого качества", – объясняет он.

Большие языковые модели — одна из самых популярных областей исследований ИИ в настоящее время, и компании спешат выпускать такие программы, как GPT-3, которые могут писать невероятно последовательные документы и даже компьютерный код. Но, по словам группы прогнозистов искусственного интеллекта, на горизонте маячит проблема: у нас могут закончиться данные для их обучения.

Лингвистические модели обучаются с использованием текста из таких источников, как Википедия, новостные статьи, научные статьи и книги. В последние годы появилась тенденция обучать эти модели на все большем количестве данных в надежде сделать их более точными и универсальными.

Проблема заключается в том, что типы данных, обычно используемые для обучения языковых моделей, могут быть исчерпаны в ближайшем будущем, уже в 2026 году. пока доступно. подвергаться экспертной оценке. Проблема в том, что по мере того, как исследователи создают более мощные модели с большими возможностями, им приходится находить все больше и больше текстов для их обучения. Ведущие исследователи языковых моделей все больше обеспокоены тем, что у них заканчиваются данные такого рода, говорит Тевен Ле Скао, исследователь из компании Hugging Face, занимающейся искусственным интеллектом, которая не участвовала в работе Epoch.

>Отчасти проблема заключается в том, что исследователи ИИ фильтруют данные, которые они используют для обучения моделей, по двум категориям: высокого и низкого качества. Граница между этими двумя категориями может быть размыта, говорит Пабло Вильялобос, исследователь Epoch и ведущий автор статьи, но текст первой считается написанным лучше и часто создается профессиональными писателями.

Данные в низкокачественных категориях состоят из текста, такого как сообщения в социальных сетях или комментарии на таких сайтах, как 4chan, и таких примеров значительно больше, чем считается высококачественным. Исследователи обычно обучают модели только с использованием данных, которые попадают в категорию высокого качества, потому что именно такой язык они хотят, чтобы модели воспроизводили. Этот подход дал впечатляющие результаты для больших языковых моделей, таких как GPT-3.

По словам Свабхи Сваямдипты, профессора машинного обучения Университета Южной Калифорнии, который специализируется на качестве наборов данных, одним из способов преодоления этих ограничений данных может быть переоценка того, что определяется как "низкое" и "высокое". По словам Сваямдипты, если нехватка данных заставит исследователей ИИ включать более разнообразные наборы данных в процесс обучения, это будет "чистым плюсом" для языковых моделей.

Исследователи также могут найти способы продлить срок службы данных, используемых для обучения языковых моделей. В настоящее время эти модели обучаются только один раз на одних и тех же данных из-за ограничений производительности и стоимости. Но может быть возможно обучить модель несколько раз, используя одни и те же данные, говорит Сваямдипта.

Некоторые исследователи считают, что когда речь идет о языковых моделях, большой не обязательно означает лучший. Перси Лян, профессор компьютерных наук в Стэнфордском университете, говорит, что есть доказательства того, что повышение эффективности моделей может повысить их производительность, а не только увеличить их размер. "Мы увидели, как небольшие модели, обученные на данных более высокого качества, могут превзойти более крупные модели, обученные на данных более низкого качества", – объясняет он.

What's Your Reaction?