Стабільна дифузія проілюстрована

Створення зображень штучного інтелекту — це найновіша функція штучного інтелекту, яка вразила людей (включно з моїми). Здатність створювати вражаючі візуальні ефекти з текстових описів має магічну якість і чітко вказує на зміну в тому, як люди створюють мистецтво. Випуск Stable Diffusion явно знаменує важливий крок у цій еволюції, оскільки він зробив високоефективну модель доступною для широкого загалу (продуктивність з точки зору якості зображення, а також швидкість і відносно низькі ресурси/пам’ять).

Після експериментів із створенням зображень AI ви можете почати дивуватися, як це працює.

Це короткий вступ до того, як працює Stable Diffusion.

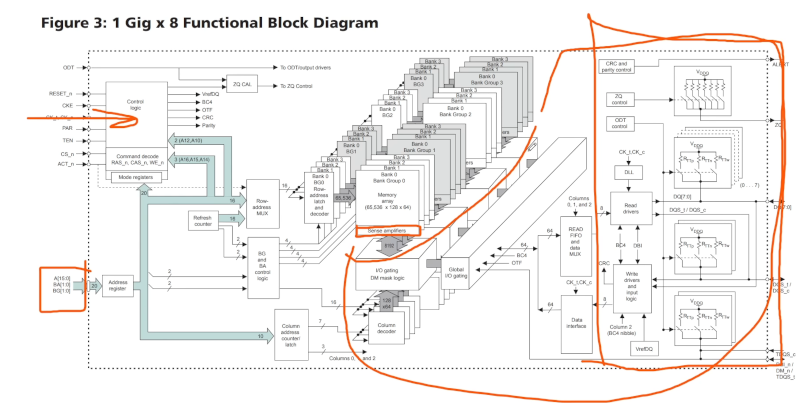

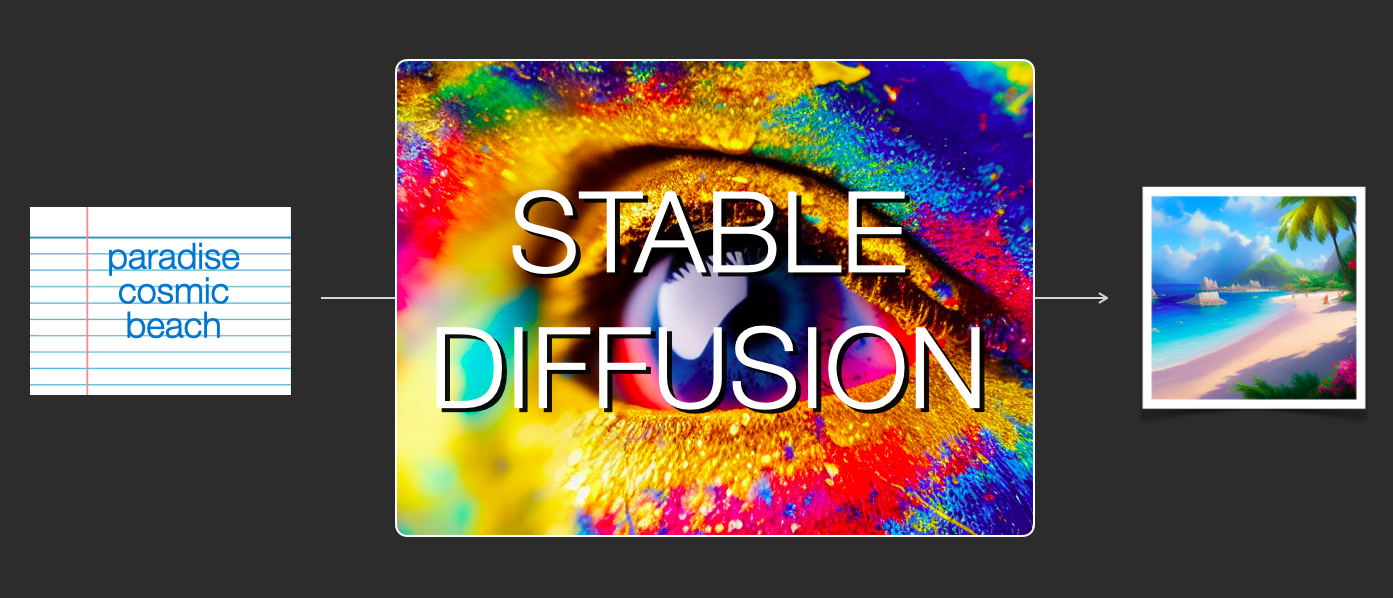

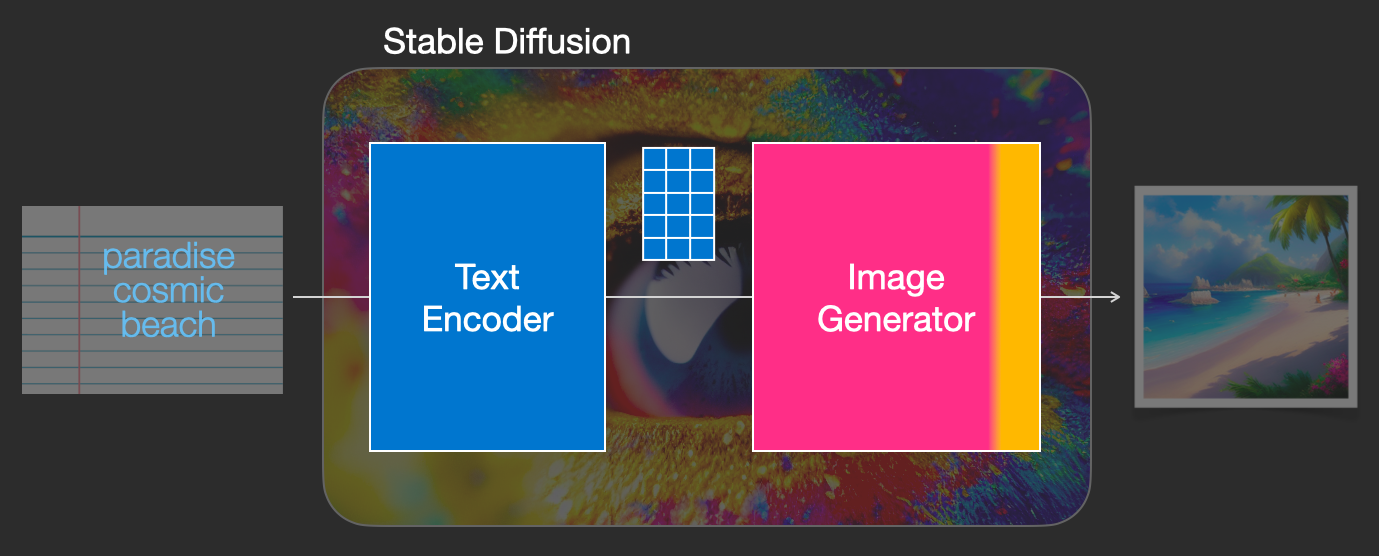

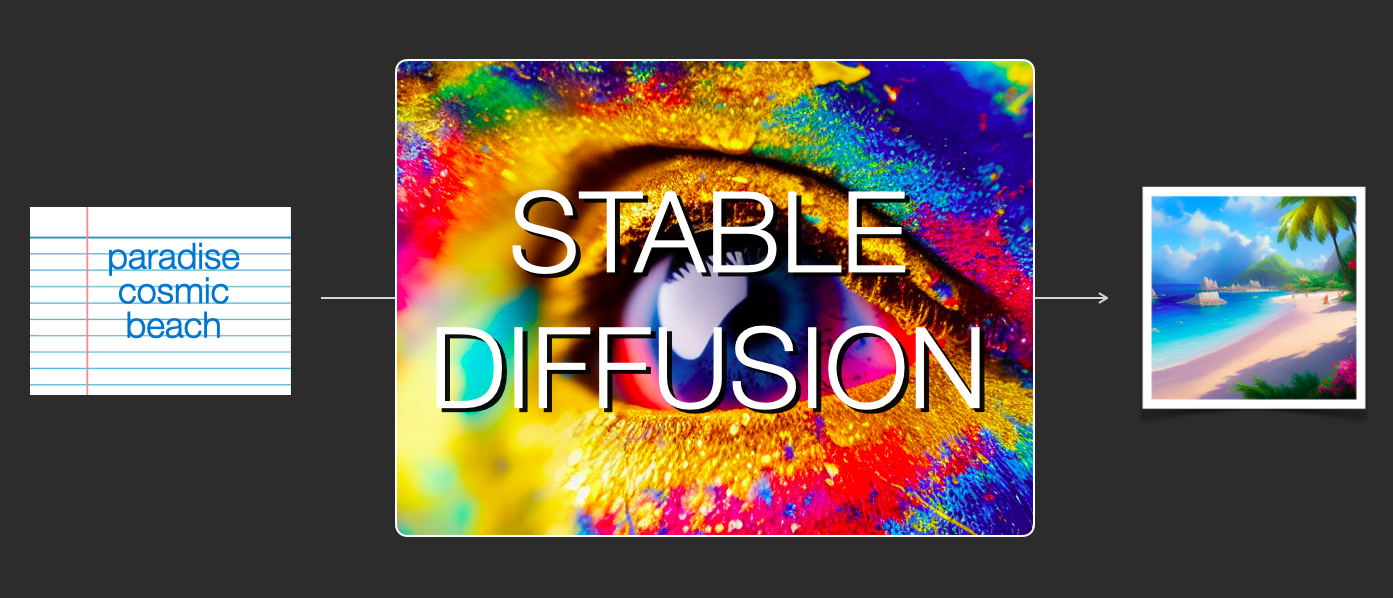

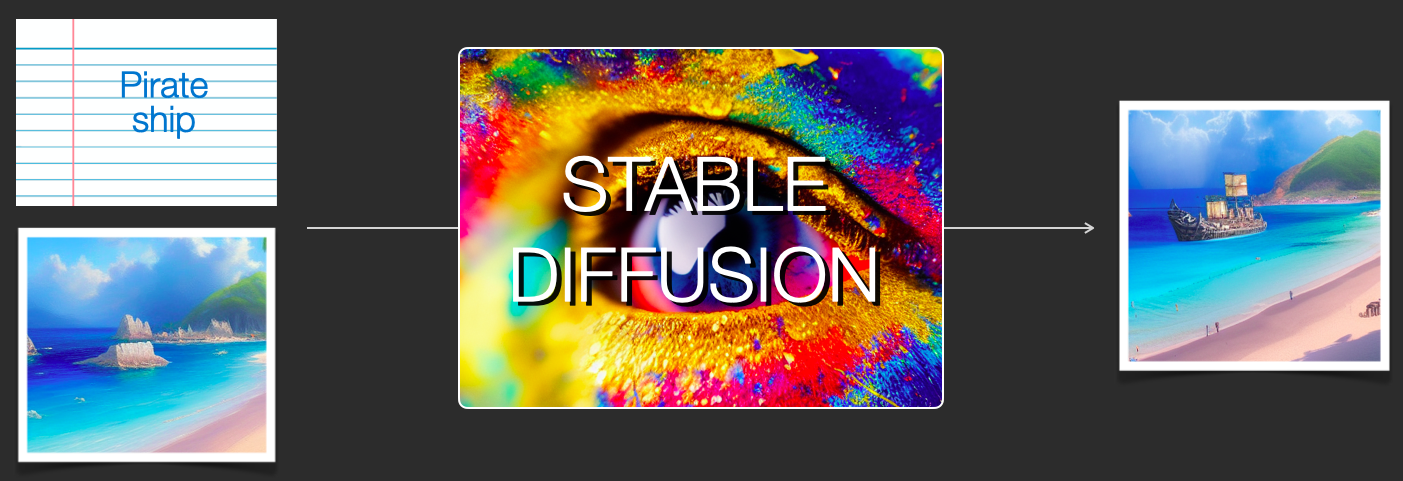

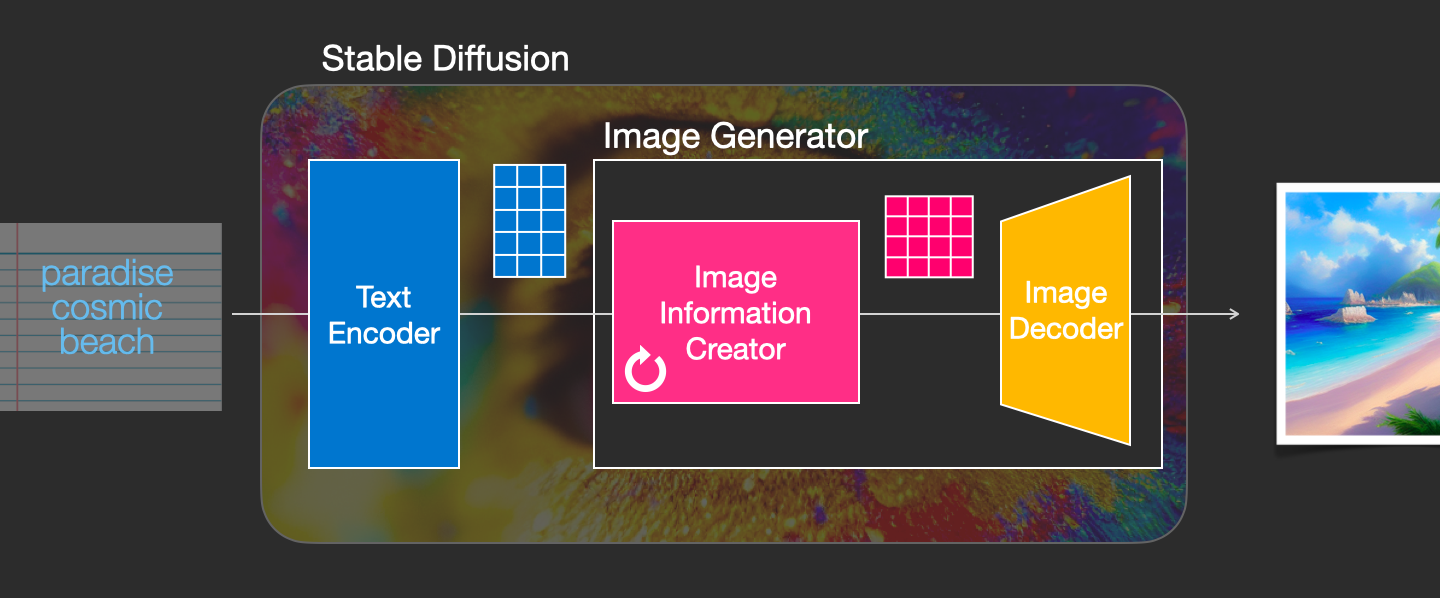

Stable Diffusion є універсальним, оскільки його можна використовувати різними способами. Давайте спочатку зосередимося на створенні зображень лише з тексту (text2img). На зображенні вище показано приклад введення тексту та створене в результаті зображення (фактична повна підказка тут). Окрім перетворення тексту на зображення, ще одним основним способом його використання є модифікація зображень (тобто вхідними даними є текст + зображення).

Давайте почнемо дивитися під капот, оскільки це допоможе пояснити компоненти, як вони взаємодіють і що означають опції/налаштування зображення.

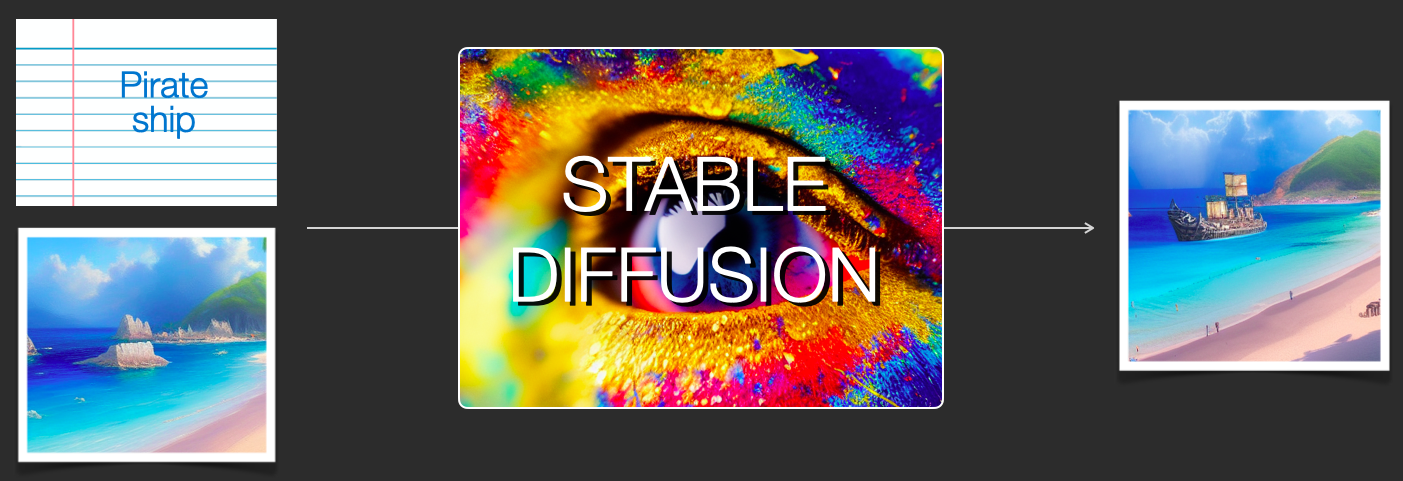

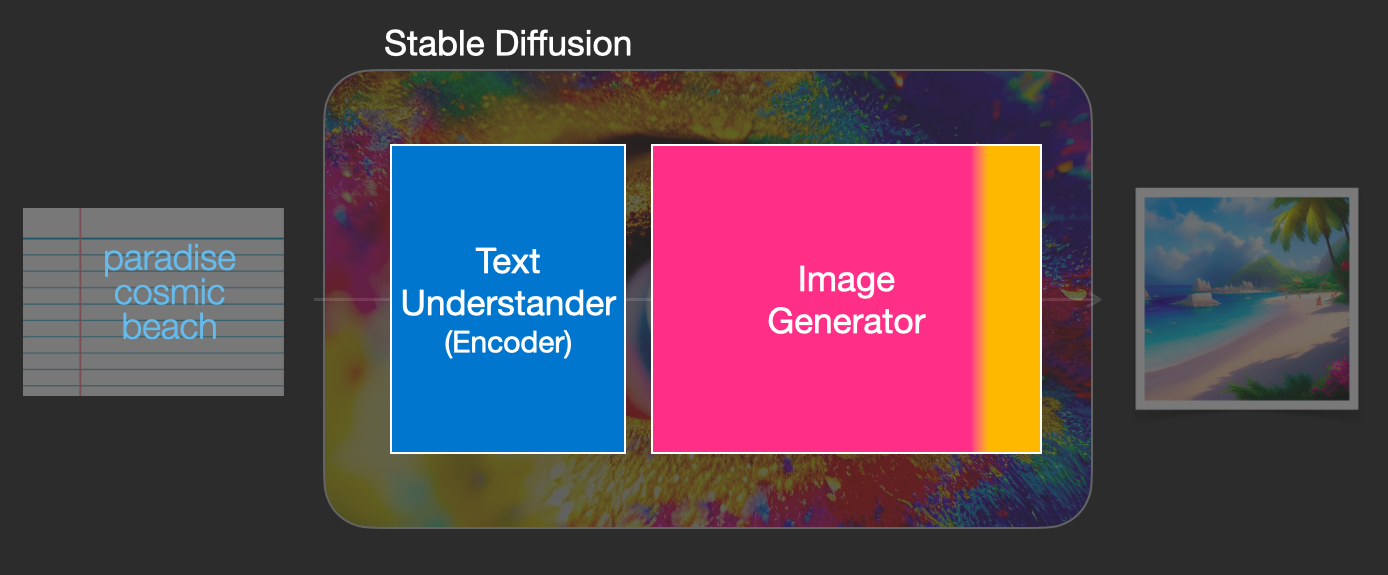

Компоненти стійкої дифузіїStable Diffusion – це система, що складається з кількох компонентів і моделей. Це не монолітна модель.

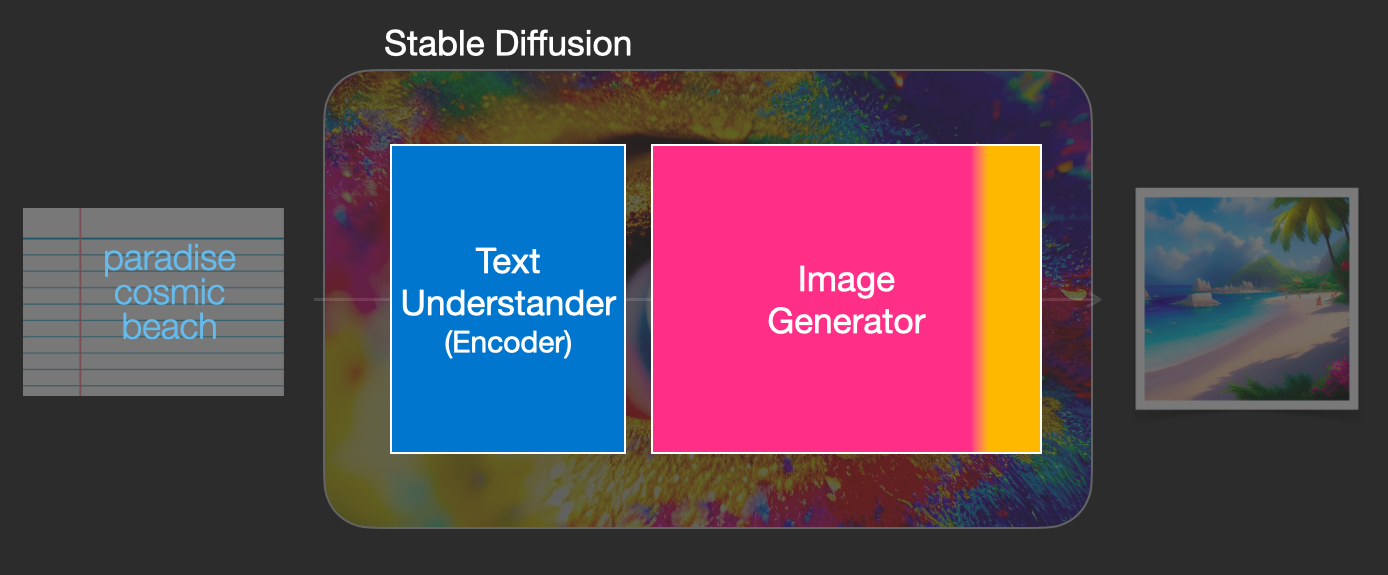

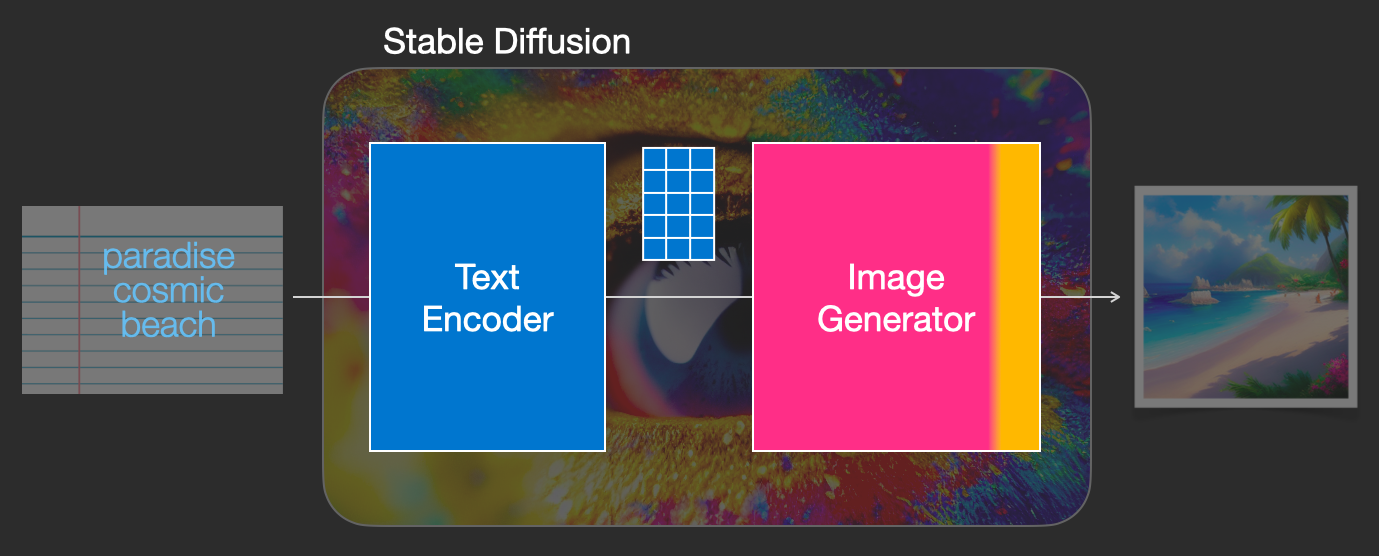

Зазирнувши під капот, перше, що ми можемо зробити, полягає в тому, що існує компонент розуміння тексту, який перетворює текстову інформацію в цифрове представлення, яке фіксує ідеї в тексті.

Ми починаємо з огляду, а далі в цій статті розглянемо докладніше про машинне навчання. Однак ми можемо сказати, що цей текстовий кодувальник є спеціальною моделлю мови Transformer (технічно: текстовий кодувальник моделі CLIP). Він бере введений текст і генерує список чисел (вектор), що представляють кожне слово/лексему в тексті.

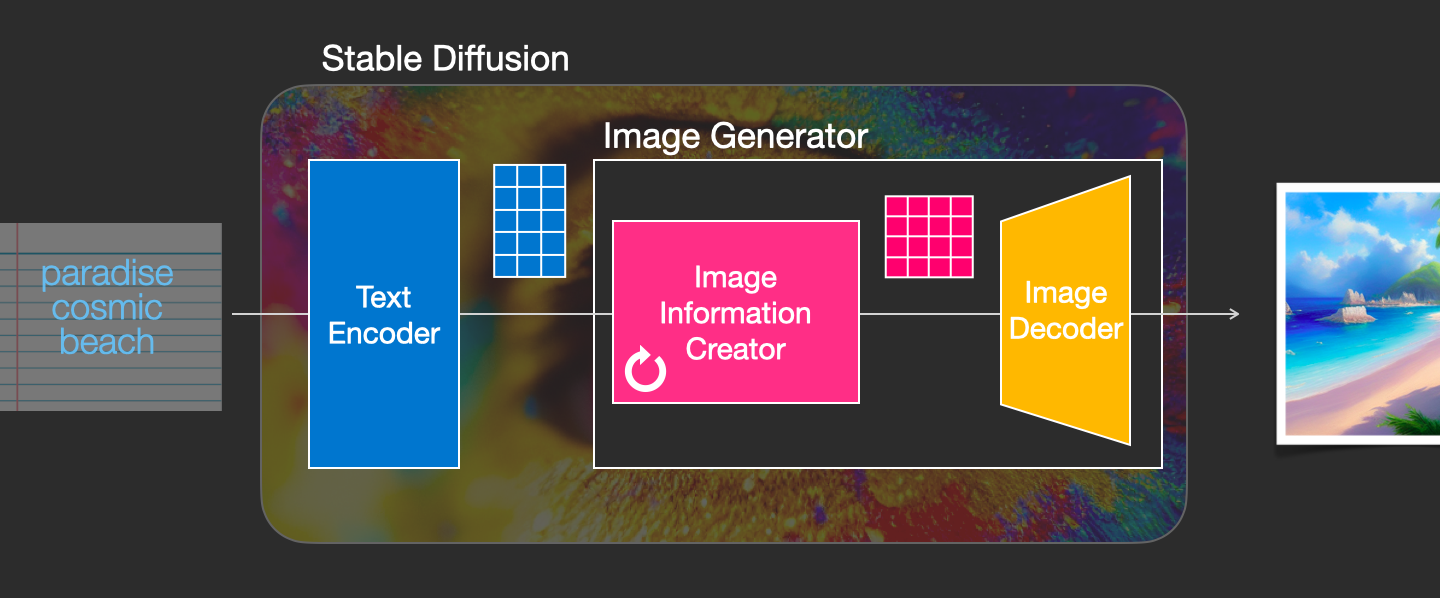

Потім ця інформація передається генератору зображень, який сам складається з кількох компонентів.

Генератор зображень проходить два кроки:

1- Створювач інформації про зображення

Цей компонент є секретним соусом Stable Diffusion. Саме тут досягнуто значного приросту продуктивності порівняно з попередніми моделями.

Цей компонент виконується в кілька кроків для створення інформації про зображення. Це параметр steps в інтерфейсах і бібліотеках Stable Diffusion, який часто за замовчуванням становить 50 або 100.

Створювач інформації про зображення працює повністю в інформаційному просторі зображення (або прихованому просторі). Далі ми поговоримо про те, що це означає. Ця властивість робить його швидшим, ніж попередні моделі трансляції, які працювали в піксельному просторі. Технічно цей компонент складається з нейронної мережі UNet і алгоритму планування.

Слово «дифузія» описує те, що відбувається в цьому компоненті. Саме поетапна обробка інформації призводить до остаточного створення високоякісного зображення (наступним компонентом, декодером зображення).

2- Декодер зображень

Декодер зображення малює зображення на основі інформації, отриманої від творця інформації. Він запускається лише один раз наприкінці процесу, щоб створити остаточне піксельне зображення.

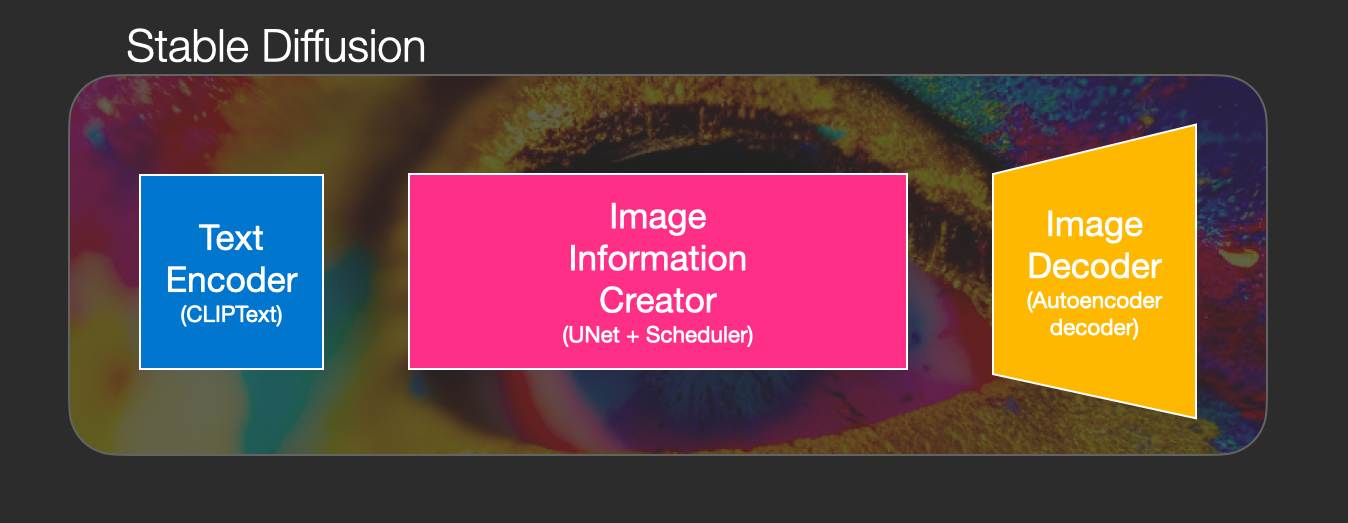

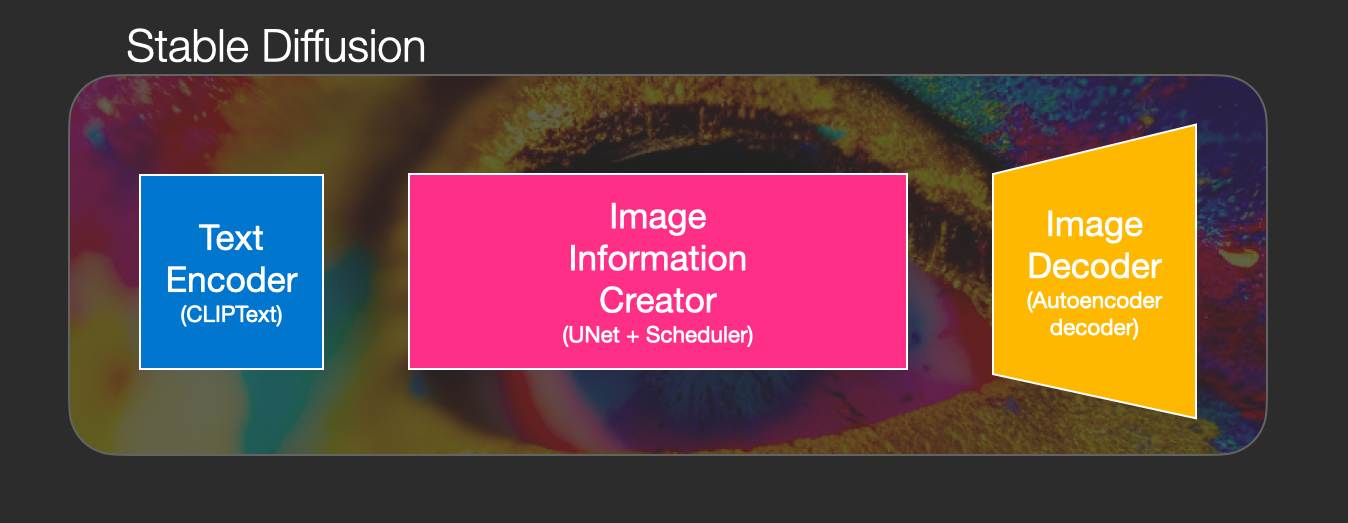

Завдяки цьому ми можемо побачити три основні компоненти (кожен із власною нейронною мережею), які утворюють стабільну дифузію:

ClipText для кодування тексту. Вхід: текст. Вихід: 77 векторів вбудовування токенів, кожен у 768 вимірах.

UNet + Scheduler для поступової обробки/розповсюдження інформації в (латентному) інформаційному просторі. Вхідні дані: вбудовані тексти та початковий тензор (структуровані списки чисел), що складається з шуму. Вихідні дані: оброблена інформація тензора

Автоматичний кодер, декодер...

Створення зображень штучного інтелекту — це найновіша функція штучного інтелекту, яка вразила людей (включно з моїми). Здатність створювати вражаючі візуальні ефекти з текстових описів має магічну якість і чітко вказує на зміну в тому, як люди створюють мистецтво. Випуск Stable Diffusion явно знаменує важливий крок у цій еволюції, оскільки він зробив високоефективну модель доступною для широкого загалу (продуктивність з точки зору якості зображення, а також швидкість і відносно низькі ресурси/пам’ять).

Після експериментів із створенням зображень AI ви можете почати дивуватися, як це працює.

Це короткий вступ до того, як працює Stable Diffusion.

Stable Diffusion є універсальним, оскільки його можна використовувати різними способами. Давайте спочатку зосередимося на створенні зображень лише з тексту (text2img). На зображенні вище показано приклад введення тексту та створене в результаті зображення (фактична повна підказка тут). Окрім перетворення тексту на зображення, ще одним основним способом його використання є модифікація зображень (тобто вхідними даними є текст + зображення).

Давайте почнемо дивитися під капот, оскільки це допоможе пояснити компоненти, як вони взаємодіють і що означають опції/налаштування зображення.

Компоненти стійкої дифузіїStable Diffusion – це система, що складається з кількох компонентів і моделей. Це не монолітна модель.

Зазирнувши під капот, перше, що ми можемо зробити, полягає в тому, що існує компонент розуміння тексту, який перетворює текстову інформацію в цифрове представлення, яке фіксує ідеї в тексті.

Ми починаємо з огляду, а далі в цій статті розглянемо докладніше про машинне навчання. Однак ми можемо сказати, що цей текстовий кодувальник є спеціальною моделлю мови Transformer (технічно: текстовий кодувальник моделі CLIP). Він бере введений текст і генерує список чисел (вектор), що представляють кожне слово/лексему в тексті.

Потім ця інформація передається генератору зображень, який сам складається з кількох компонентів.

Генератор зображень проходить два кроки:

1- Створювач інформації про зображення

Цей компонент є секретним соусом Stable Diffusion. Саме тут досягнуто значного приросту продуктивності порівняно з попередніми моделями.

Цей компонент виконується в кілька кроків для створення інформації про зображення. Це параметр steps в інтерфейсах і бібліотеках Stable Diffusion, який часто за замовчуванням становить 50 або 100.

Створювач інформації про зображення працює повністю в інформаційному просторі зображення (або прихованому просторі). Далі ми поговоримо про те, що це означає. Ця властивість робить його швидшим, ніж попередні моделі трансляції, які працювали в піксельному просторі. Технічно цей компонент складається з нейронної мережі UNet і алгоритму планування.

Слово «дифузія» описує те, що відбувається в цьому компоненті. Саме поетапна обробка інформації призводить до остаточного створення високоякісного зображення (наступним компонентом, декодером зображення).

2- Декодер зображень

Декодер зображення малює зображення на основі інформації, отриманої від творця інформації. Він запускається лише один раз наприкінці процесу, щоб створити остаточне піксельне зображення.

Завдяки цьому ми можемо побачити три основні компоненти (кожен із власною нейронною мережею), які утворюють стабільну дифузію:

ClipText для кодування тексту. Вхід: текст. Вихід: 77 векторів вбудовування токенів, кожен у 768 вимірах.

UNet + Scheduler для поступової обробки/розповсюдження інформації в (латентному) інформаційному просторі. Вхідні дані: вбудовані тексти та початковий тензор (структуровані списки чисел), що складається з шуму. Вихідні дані: оброблена інформація тензора

Автоматичний кодер, декодер...

What's Your Reaction?